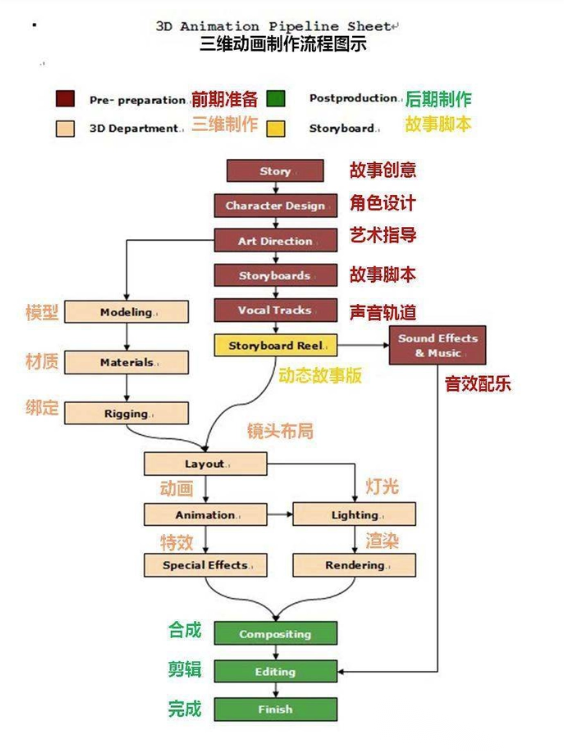

Les œuvres d'animation CG traditionnelles ont souvent des images extrêmement belles et des normes de production extrêmement élevées, mais elles posent également des problèmes tels qu'un long cycle de production, un seuil professionnel élevé et un investissement en capital important. L'essor des produits vidéo et le besoin urgent d'une production vidéo nationale reflètent de plus en plus les barrières de la production d'animation traditionnelle. Le plus gros problème est que la production et la présentation en temps réel ne peuvent pas être réalisées. Il est souvent nécessaire de décomposer des scènes d'animation et d'embaucher des animateurs pour compléter la production d'images clés. , le flux de travail est complexe et il est impossible de prévisualiser les résultats et de les optimiser à temps pendant le processus de production.

L'émergence de la 【technologie de capture de mouvement du corps entier 】 apporte une innovation révolutionnaire aux animateurs

Virdyn recherche et développe de manière indépendante une technologie de capture de mouvement du corps entier et de capture d'expression faciale. Grâce à un véritable équipement de capture de mouvement portable, les mouvements et les expressions du corps du porteur peuvent être capturés de manière efficace, stable et précise, et les données de capture de mouvement peuvent être enregistrées en temps réel dans le logiciel de capture de mouvement VDmocap. Et exportez/lisez/modifiez les données de capture de mouvement pour générer rapidement des fichiers fbx/bvh.

Les fichiers de mouvement fbx exportés via le logiciel de capture de mouvement VDMocap peuvent être importés dans Maya, 3DS MAX, Unity, Unreal et d'autres outils d'application et logiciels compatibles avec l'industrie, et peuvent être utilisés pour la liaison avec le modèle et la lecture du lecteur, par rapport à l'animation traditionnelle Méthode K-frame, la bénédiction de la technologie de capture de mouvement est très efficace pour raccourcir le temps de cycle de production d'action.

1. Capturez les données de mouvement basées sur VDsuit Full

2. Exportez les fichiers de capture de mouvement à partir du logiciel de capture de mouvement

3. Importez les données de capture de mouvement dans le logiciel

4. Créez des acteurs et alignez-les avec les nœuds de capture de mouvement

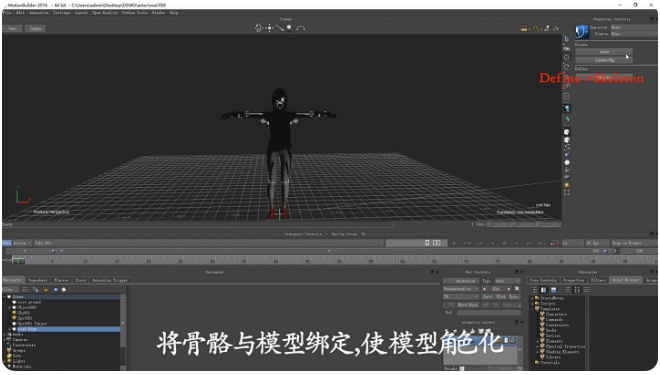

5. Lier les nœuds de capture de mouvement aux acteurs

6. Enregistrer l'acteur en tant que fichier FBX

7. Importer le modèle d'application

8. Liez le modèle et fusionnez les os

9. La présentation finale des données de capture de mouvement en 3Dmax

Autonomisation technologique, industrie gagnant-gagnant

Virdyn, se concentrant sur la recherche et le développement de la technologie de fusion multi-capteurs et de la technologie d'interaction homme-ordinateur, a indépendamment développé et breveté des produits de capture de mouvement inertiel série VDsuit, des gants de capture de mouvement et la plate-forme de système de diffusion en direct virtuel VDLive, qui ont été largement utilisés dans cinéma et télévision, animation, VR/AR, jeux, diffusion en direct et autres industries, et forment des solutions d'atterrissage matures dans chaque domaine, intégration hautement technique, entrée à faible coût, autonomisation de la production d'animation cinématographique et télévisuelle et développement de jeux et d'autres industries, ouverture Pour améliorer le processus de pré- et post-production de l'animation, les plug-ins SDK n'ont pas de logiciel grand public Seam butt 3D ni de moteur VR.

Heure de publication : 26 octobre 2022